- · 电子信息对抗技术版面费[08/04]

- · 《电子信息对抗技术》投[08/04]

如何摆脱信息茧房?(3)

作者:网站采编关键词:

摘要:Y= F(Xi ,Xu ,Xc) ,这三个函数包含三个维度的变量分别为: 1)内容,2)用户特征,3)环境特征 三者匹配起来是一个复杂的数学问题;市面常用模型有好几

三者匹配起来是一个复杂的数学问题;市面常用模型有好几种,字节系无非是把多模型混合使用,简单来说就是:你是谁、你在哪里、你爱看什么?基于这些给你推荐什么。

一般当推荐系统的自动化运作时,它就像山头巡视的小兵,不断从整个物品或者信息聚合中抽取当次需要查询的候选集;根据各种不同维度,如物品、年龄、性别、爱好,场景等种类以及规模的大小对候选集进行推送。

此场景犹如流水线工作的「抽样检查」,也同样用在大部分平台的召回手段上,具体策略是什么样呢?

其一:内容过滤(Content Filtering)

其二:协同过滤(Collaborative Filtering)

资讯类产品的内容审核是不可缺失一部分,主要目的是确保无低质庸俗,保持平台该有的调性;通常有“先发后审”和“先审后发”两个原则。

场景较轻如网易云,QQ音乐此类阅读、听歌类产品通常是前者;对社区论坛、偏观点讨论、树立权威通常是后者;因此内容抽检或过滤的基础也是查敏感关键词、重复度、IP发布次数等权重指数。

协同过滤是基于已知部分用户或部分物品的偏好或评分,预测缺失偏好或评分的一种方法。

从切入点上,则可分为基于“去邻域”的方法(本地生活类平台使用居多)和隐语义模型(给每个分类中不同维度标签的人进行推送),比较难理解对不对?

举个例子:

跟朋友聚餐会习惯性打开美食点评平台去搜索周边餐厅,过程中我们能看到按照公里排行的推荐、也有部分商家的竞价广告。

疑问的是,你会发现那些广告的美食是自己日常爱吃的,并且区域也不是太远,为什么会这么做?

因为可以基于“邻域”做精准的推荐,以此满足用户多频次的消费和深度洞察;如果把“邻域”比作数学的“2”,它左手链接“1”,右手链接数字“3”。

去邻域算法就是把“1”推荐给“3”,假设不做去中心化折中结果就是上述你看到场景,基于自己搜索习惯、爱好、距离做折中推荐。

对于人工干预比较容易理解,基础的说我基于某类标签做手动推送,如:性别类型、兴趣爱好、话题、KOL量级等。

高维一点会融会贯通几项不同的数据综合考量,好比针对女人中对护肤话题感兴趣,客单价又在多少区间等。

这种方式常见在中小型(百万级用户量)以上的平台,主要特征表现在技术的基础建设已经完成,属于发展中期还完全不能依靠自动化解决。

一方面防止有巨大漏洞出现,造成损失。

另一方面也能运用人工的方式灵活多维度的基于用户(商品)进行推送,比如基于点击率作为推荐指标时,排序算法筛选后,我们会以预测结果为目标。

这些场景中就会用到因子分解,逻辑归因,梯度提升决策树,以及各种神经网络算法,这一切也把它称之为“混合模型”。

但不管怎么样始终都离不开那两大原则“基于用户行为”和“基于内容”;综合上述,我们能得到什么启发呢?

企业招聘大量研发人员,利用理科的思维逻辑将人的行为特征变成“数据化”,由数据进行颗粒化,最终通过个性化的分析让平台更了解每个人,也就有了那句感同身受的话“我都没有平台了解我自己”。

但真的是这样吗?这种理解就狭隘了。

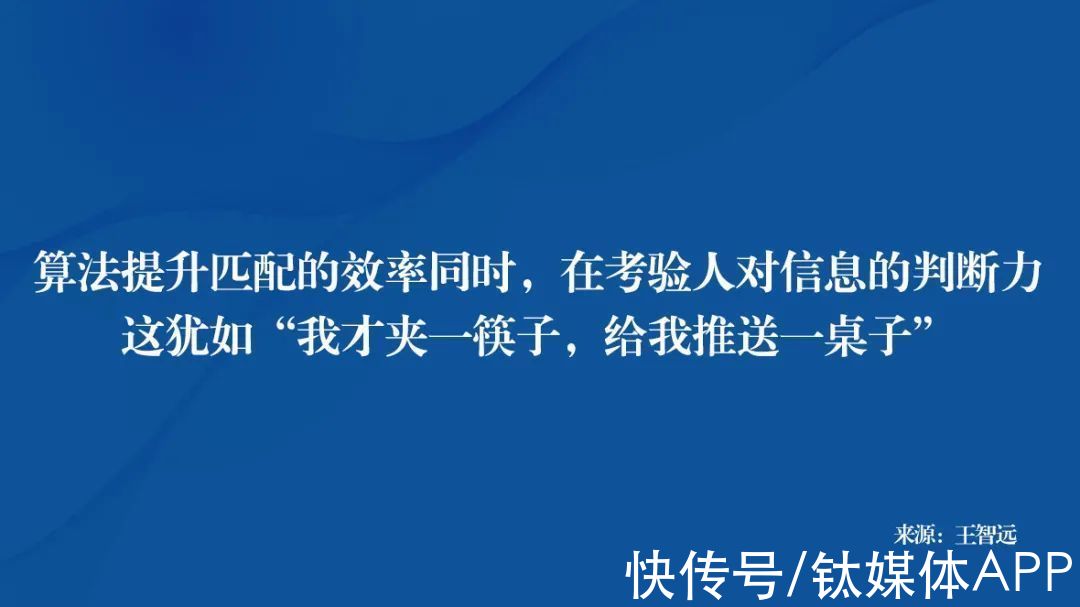

你以为平台很了解自己?其实我们不过是把爱好,需求形成的特征进行标签化沉淀在平台上,这造成推荐的内容都在自身的“认知圈内”。

简而言之,每个人在头部资讯(购物)平台看到的展示页均不同,他代表一个人的视野和爱好,这仿佛似一面镜子疯狂的为你展现热爱的一面,它带来的利弊也是极为可见。

孰是孰非从优劣上有两个方面:

一是良好的认知能力,二是陷入回音室效应。

如果我们能够正确认知到信息茧房如何由来的,或者算法如何基于自身的各种行为形成“虚拟人设”为你定做线上画像;加上我们能够辨别哪些信息是优质的,哪些是不能为我所用,那就不存在“茧房”。

这就给我们最大的启示是,

文章来源:《电子信息对抗技术》 网址: http://www.dzxxdkjs.cn/zonghexinwen/2021/1217/423.html